引言

数据库中间件承担应用与数据库之间的粘合与润滑,数据库中间件设计的合理应用跑起来就丝滑,否则会拉胯。本文就常见数据库组件相关的功能设计点做个归纳整理:

- 分库分表

- 数据复制

- 数据同步平台

- 全局唯一主键

- 运维自动化可视化

一、分库分表

分库分表组件主要为分担数据库压力,通过多库多表承接请求。尽管拥有众多的分库分表组件,Apache ShardingSphere作为Apache的顶级项目依旧是主流。无论直接使用还是基于其二次开发或者自研,均值得研究。

1.ShardingSphere-JDBC

客户端直连数据库,分布式无中心化,主要针对java语言,数据库连接消耗多。

2.ShardingSphere-Proxy

客户端先连接到Proxy代理,通过代理连接数据库,能够跨语言,消耗数据库的连接数少(仅代理直接连接数据库),但是中心化风险点也主要在此。

3.ShardingSphere-Sidecar

网格化代理还在规划中,从当前蚂蚁对外提供的service mesh商业方案中,还没DB的mesh,下沉能力的同时,也带来了数据面和控制面板的复杂性。

https://github.com/apache/shardingsphere.git

备注:当前还是客户端直连数据库为主流,中心化的Proxy依然有公司采纳然占比依旧很少,至于Sidecar模式的大规模使用还在未来。

二、数据复制

1.单向搬运

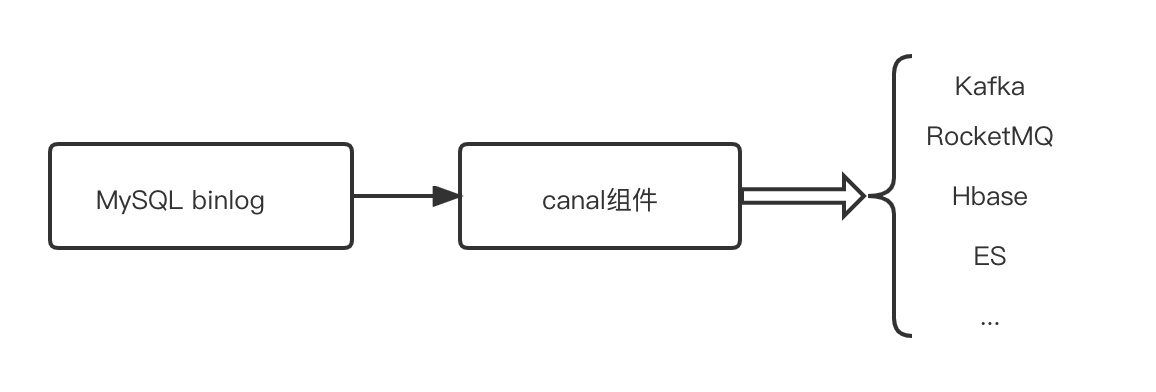

将Mysql数据同步到消息队列或者其他数据存储源,常用开源组件为canal。

https://github.com/alibaba/canal

2.双/单向同步

在异地多活场景中数据库的双向同步、跨机房灾备的单向同步等场景,常用组件otter。

https://github.com/alibaba/otter

其他类似组件:datalink、databus

https://github.com/ucarGroup/Datalink

https://github.com/linkedin/databus

备注:在单/双向同步场景中通常伴随着DDL的同步。

三、数据同步平台

当随着数据同步的场景越来越多,为每个不同的数据源写一个同步插件变得复杂和不好维护,此时可以考虑搭建一个数据同步平台。

- 通过ReaderPugin和WriterPlugin插件化

- 插件化对接入的数据源和目标数据源只需要编写插件即可

- 数据转换为提高吞吐性能可以引入Flink批处理框架

备注:数据同步平台社区也有开源DataX可供参考。

https://github.com/alibaba/DataX/blob/master/introduction.md

Flink-CDC

https://github.com/ververica/flink-cdc-connectors

四、全局唯一主键

在分布式数据库中最好使用分布式全局唯一ID作为数据记录的唯一标识,原因也很简单,主要是避免主键冲突。

- 跨库数据迁移避免主键冲突

- 双活数据库双向同步时避免主键冲突

- 唯一键设计合理对排序和识别均有良好的辅助作用

生成全局唯一ID的方案有很多,常见的有:

- UUID

- 数据库发放不同的ID区段

- 雪花算法(snowflake)生成唯一标识

雪花算法: 由Twitter创建生成全局唯一ID算法,一个Snowflake ID组成共64位构成如下,如果不需要这么多位可以改造缩短一些长度。

Twitter Scala 版本:

https://github.com/twitter-archive/snowflake/tree/scala_28https://github.com/twitter-archive/snowflake/releases/tag/snowflake-2010

雪花算法java版本参考:

https://github.com/beyondfengyu/SnowFlake/blob/master/SnowFlake.java

五、运维自动化可视化

将常用的一些与DB相关需要手动的创建的自动化、可视化。

- 数据库申请与创建

- DDL变更自动化

- SQL执行结果导出

- 同步任务申请自动化

- 任务运行监控可视化

免责声明:本平台仅供信息发布交流之途,请谨慎判断信息真伪。如遇虚假诈骗信息,请立即举报

举报